早些年,人们提起人工智能的第一反应可能就是仿生机器人。而随着科技的发展普及,人工智能逐渐褪去神秘面纱,智能客服、语音识别、图像分类等应用,开始成为我们智能家居中、手机里都随处可见的事物。

我们看到,这个世界上由人工智能来把守的关口逐渐增多。而与此同时,能够借由人工智能来攻陷的关口也越来越多。

随着AI安全技术的不断升级,再加上攻防对抗的螺旋式上升,一些诸如窃听风云、AI谍战的影视剧抓马桥段,离我们的现实生活越来越近。

这一年,我们持续探索AI安全,做了很多不同主题的AI攻击可行性测试和模型优化实验,以更好地发现可被利用的漏洞或缺陷,建立起更安全可靠的防御机制。下面,基于团队过往研究实践,为大家盘点10种仿若“魔幻照进现实”的AI技术。

1. 听音辨位不止存在于武侠小说

听音辨位——这种武侠小说里的武林绝学,正在通过AI技术的发展成为可能。

每个人走路都会有自己的习惯,而脚步声则是体现这些细节的线索之一。当目标人员的脚步声被收集起来,并用AI模型训练后,模型能够凭借脚步声信息,判断目标人员的行动轨迹,如左转、右转、直行等。

根据这个原理,我们在相对安静的环境下采集了一批脚步声数据,做了一次“听音辨位”的实验(→传送门),经过调试优化,最终平均准确率达90%以上。实验证明,通过脚步声获取个人行踪信息,具备技术可行性。

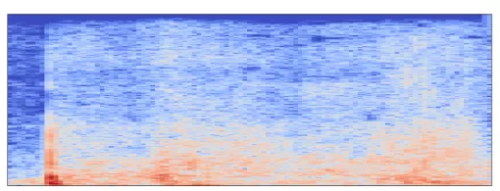

图:单个脚步声的频谱图

2. AI预判了你的预判

预判,是AI非常在行的一件事。基于过往大量既定事实数据的训练,AI可以高效地做出很多令人惊艳的预测。

在预测人的密码方面,AI就很有一套。AI通过学习分析大量用户泄漏的历史密码,能够掌握目标人员变换密码的习惯与思想,由此生成更有效的密码候选集,提升密码命中率。

在设置不同网站密码时,每个人都有自己的习惯:有人喜欢变换首字母大小写,有人喜欢把词组进行交叉重组,有人习惯用特殊字符来分割字母和数字,还有人习惯关联到身边熟悉的、或有特定意义的事物,比如姓名、电话、生日、组织名称简写、短语简写等。基于这几种常见的用户习惯,我们做了一系列AI猜密码的实验,欢迎围观(→传送门)。

图:AI模型基于人员属性预测密码

3. 看穿马赛克

相信每个老司机,都曾在深夜思考过清除马赛克的方法。如今借助AI神经网络,“看穿马赛克”这事已不再是难题。

打马赛克,也就是在原始图像中,用一个邻近区域的像素值替换整个区域的像素值,这个区域越大,图像越模糊。而利用神经网络,该区域的内容能在一定程度上被重构和复原。

我们以中文文本为例,做了一次清除马赛克的实验(→传送门)。总的来说,马赛克遮盖的部分其实包含了文字的位置和纹理特征,恢复这段文本主要有两步:先用AI模型提取马赛克图像特征,再来指导模型生成文本描述,从而还原被遮盖的内容。

实践证明,在神经网络的学习和推理下,马赛克也可能被“看穿”,一秒实现有码变高清。

图:马赛克清除

4. 敲键盘也能泄露信息?

有时候,你的键盘敲击声,也可能成为泄漏秘密的声音源。

万物皆有规律,只要是声波,都有其自身的音频特征。打字的时候,键盘上的各个键被敲击时,发出的声音都有着细微的差异。各个击键音之间的差异,人耳听不出来,但AI可以。

通常情况下,几乎没人会去刻意隐藏自己敲键盘的声音。当特定键盘的每个击键音被记录下来,经过计算机处理,就能发现键与键之间发音的区别。而通过AI训练后的窃听设备,可以从声音中辨认敲打的键盘字符,进而读取敲打的文字内容。

图:某击键音的MFCCs音频特征

5. 来电有诡

在AI技术的加持下,电话诈骗也变得越来越神乎其技了。当AI技术和网络攻击手法被精心组合,攻击者只需两步,即可实现迷惑性极强的电话诈骗——

第一步,篡改“看到的”。来电显示上的“号码”及“呼入姓名”,都能通过VoIP电话劫持的方式被篡改。早期版本的VoIP,存在被网络嗅探并实施中间人攻击的风险,攻击者利用漏洞,能将接听方的来电显示预设为任意内容,比如你熟悉的一个号码,比如你的老板。

第二步,仿造“听到的”。语音合成并不新鲜,基于深度伪造 AI 变声技术,基本只需数秒目标人物的音频素材,就能够得到逼真的合成音频。

因此,即使来电显示ID是你的老板,号码也是你老板,连话筒传来的声音也跟你老板一模一样,但对方也可能是个搞诈骗的。

图:整体流程

6. 复刻笔迹,没人比得过AI

笔迹就好比指纹,可以说是每个人特有的标志之一。但现在,AI不仅能模仿你的脸,还能模仿你的字。

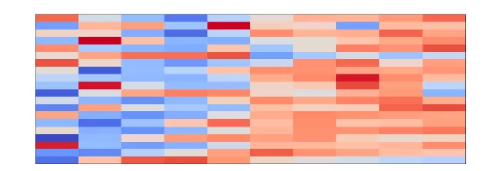

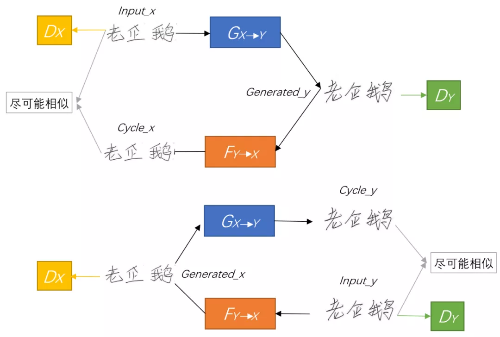

AI模仿人类笔迹,主要借助生成对抗网络。我们也做了一次通过AI模拟家长签名的实验(→传送门),100%模拟还原了目标人物的笔迹。实验中,主要利用两个网络来分别进行内容提取与风格提取。也就是将提取出的内容特征和风格特征作用于生成对抗网络,使其生成对应风格的文字,并替换原始图片中的文字,实现风格刷的作用。

撇开冒签家长签名不说,AI笔迹模拟这项技术可能会被不怀好意者利用,比如制造书法赝品、侵犯字体版权、冒签重要合同等。

7. 论阅后即焚的重要性

一个温知识——办公室里藏秘密最多的地方,可能是文印室里的碎纸机。

历史案例和众多影视作品告诉我们,即使是用碎纸机来销毁文件资料,碎纸片也有可能被拼接复原。当然,人工拼接耗时耗力,随着计算机技术的发展,业界开始引入AI来解决碎纸拼接的效率问题。

利用AI实现碎纸自动拼接的核心思想,简言之就是“找出碎片图像的邻居”,具体可分为碎片特征提取、碎片两两匹配、碎片整体拼接三大步骤。我们基于这个思路,做了一次简单实验(→传送门)。实验中,利用训练好的AI模型进行自动拼接,耗时不到1分钟,即可得到一张误差率小于5%的拼接图像。若采用纯人工拼接的方式,大约需耗时30分钟。

目前,该技术已逐步应用在司法物证复原、军事情报获取、历史文献修复等场景。当然,也可能被不法分子用于窃密。因此当我们销毁重要文件时,能让它碎成渣渣就不要手软,碎纸颗粒也要妥善处理。

图:碎片自动拼接主要步骤

8. “照骗”能骗到什么程度

顶级的“照骗”,不仅能骗人,还能骗过AI图像识别模型——只需要一招“缩放图片攻击”。当图像经过缩放算法处理后,AI能把大狗狗认成小猫咪,把长臂猿认成大熊猫,详情可见实验(→传送门)。

举个例子,将一张小猫的图片作为目标图像,同时将一张广告图作为源图像,利用缩放攻击得到修改后的攻击图像。由下图看到,在保持原尺寸时,源图像和攻击图像在视觉上几乎没差别,而当攻击图像被缩放到指定尺寸时,看起来则与目标图像几乎一致。而且经验证,AI图像识别模型也被蒙骗,把广告图这张攻击图像识别成了小猫。

图:缩放攻击示意图

“照骗”本身不可怕,可怕的是对照骗的恶意利用。比如,被用于绕过广告内容审核,进行欺诈式营销;比如,向公开数据集注入攻击图像,实施数据投毒。

9. 假如有一天,搜索引擎欺骗了你

写论文查文献、做菜搜食谱……网上冲浪时,信息搜索无疑是个高频行为。

当前的信息检索算法,很多都是基于神经网络设计的模型来优化的。然而,神经网络的脆弱性,也将更多安全隐患引入了信息检索领域。

本着以攻促防的目的,我们也做了一次“扰乱搜索排名”的实验(→传送门),并得到结论:对检索对象增加对抗扰动,能够扰乱搜索相关性排名。一旦信息检索算法被攻击,检索结果出错,将导致用户被误导、被欺诈。

试想一下,当你在Google搜新闻、在知网查询学术文献时,搜索结果却混进了乱七八糟的黄色废料……基于神经网络脆弱性带来的信息检索攻击风险,这一切随时可能发生。不法分子通过这种攻击,能够定向输出种族主义言论、传播黄赌毒信息等。因此,重视这里面的风险并提前防范尤为重要。

图:100个样本加入同一个trigger后,与当前查询词的相关性得分变化

10. 你看到的“新闻”,可能是AI瞎掰的

你看到的“新闻”,可能是由AI瞎掰出来的。此前,一位美国小哥就利用AI在博客上写鸡汤文,结果疯狂涨粉,且大部分人都没发现这不是人类写的。

简单而言,AI模仿人类语言习惯生成文本,原理就是基于语言模型,根据已有句子的一部分,来预测下一个单词会是什么,我们平时使用的输入法就是一种典型应用。通过无监督学习,AI模型能够学会词语之间的语法搭配规则,进而根据提示信息,生成新的文本。

此前,我们就做了一次AI写作模型优化的实验(→传送门)。实验证明,经过模型微调和算法优化,AI能够从“胡言乱语”进步到“出口成章”,生成逻辑清晰、叙事流畅的文本,万字长文也是分分钟能搞定的事情。

图:GPT2模型训练过程

不过,有多智能,就有多大杀伤力。这项技术如果被滥用,可能会造成大规模的谣言传播、错误信息充斥、虚假新闻泛滥等现象,这就很可怕了。

写在最后

技术发展日新月异,安全对抗持续迭代。当科幻真正变为现实时,惊奇感往往不会延续很长时间,它们很快会成为我们生活中司空见惯的一部分——

手机里的满屏应用、昼夜穿行的自动驾驶汽车、客服电话那头的机器人妹子、工厂中繁忙的自动化流水线、医院里的智能病症诊疗系统……但凡任何一个点被攻击者突破,都会带来难以估量的严重后果。

但我们也始终相信,只要技术择善而从,能力向善而行,人工智能的发展就是推动创新的船桨,能够帮助人们摆渡到未来美好世界的彼岸。

Copyright © 2005-2021 网信安全世界版权所有

Copyright © 2005-2021 网信安全世界版权所有